這年頭,安卓廠商沒個大模型,都不敢開手機發布會了。

前腳OPPO剛用大模型升級了語音助手,后腳vivo就官宣自研手機AI大模型;

小米發布會則直接將大模型當場塞進手機系統……其競爭激烈程度,不亞于搶芯片首發。

到底是怎么回事?

究其原因,還是智能終端已經成為了各類AIGC應用的落地“新灘頭”。

先是圖像生成大模型接二連三地被塞進手機,從十億參數的Stable Diffusion,在手機上快速生成一只金毛小狗:

△圖源油管Android Authority

到手機上運行十五億參數的ControlNet,快速生成一張限定圖像結構的AI風景照:

隨后,文本生成大模型們也爭先恐后地推出了手機新應用——

國內有文心一言、智譜清言APP,國外則有OpenAI的移動版ChatGPT,Llama 2手機版也在加急準備中。

現在,這一波智能終端大模型熱潮之中,最底層的軟硬件技術齒輪開始轉動。

從高通到蘋果,最新的芯片廠商發布會,無一不在強調軟硬件對機器學習和大模型的支持——

蘋果M3能運行“數十億參數”機器學習模型,高通的驍龍X Elite和驍龍8 Gen 3更是已經分別實現將130億和100億參數大模型裝進電腦和手機。

并且這不僅僅是已支持或跑通的數字參數,而是實實在在到了可落地應用的程度。

△高通現場演示和手機中的百億大模型對話

從十億到百億,更大參數的移動端AI模型暗示了更好的體驗,但也意味著一場更艱巨的挑戰——

或許可以將這樣機遇與挑戰并存的大模型時代,稱之為「模力時代」。

「模力時代」下,芯片廠商究竟要如何沖破大模型移植智能終端面臨的算力、體積和功耗等限制?

進一步地,大模型的出現又給底層芯片設計帶來了哪些改變?

是時候掰開揉碎,好好分析一番了。

「模力時代」,硬件圍繞AI而生

從大模型風暴刮起之初,算力就成為了科技圈的焦點話題。

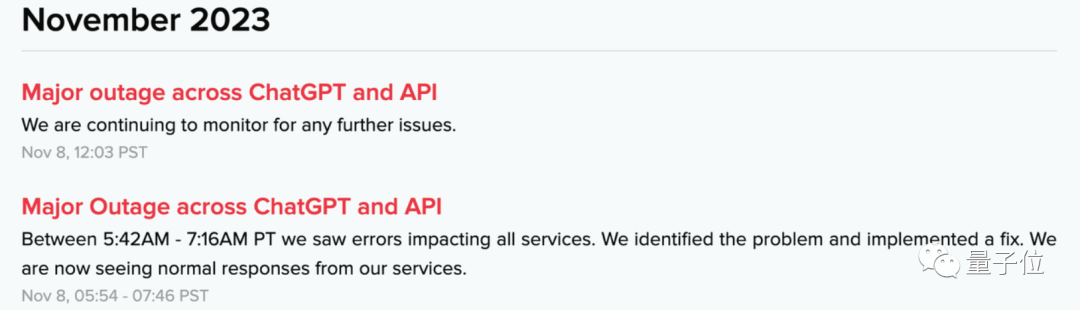

就在最近,OpenAI還因為DevDay后“遠超預期”的大模型調用流量,出現了全線產品宕機的史上最大事故。

相比于云端,移動終端的算力更為受限。想要把大模型裝進手機,算力問題自然構成了第一重挑戰。

計算單元之外,有限的內存單元,是大模型進手機面臨的第二道難關:大模型推理需要大量計算資源做支撐,與此同時,內存大小決定了數據處理速度的上限以及推理的穩定性。

另外,在手機上跑大模型,也給電池帶來了更大的壓力。因此芯片能耗成為一大關鍵。

在各大廠商的最新探索之中,我們可以觀察到,解決之道目前分為軟、硬兩路。

先來看硬件部分。

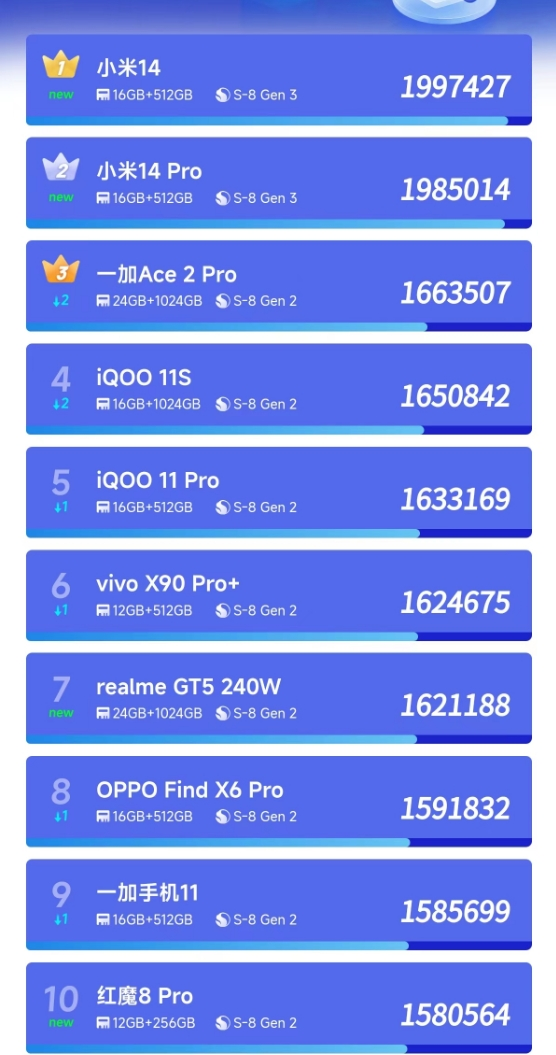

高通最新推出的第三代驍龍8移動平臺,就被定位為高通“首個專門為生成式AI打造的移動平臺”:

能夠在終端側運行100億參數大模型,面向70億參數大語言模型,每秒能生成20個token。

較之前代產品,第三代驍龍8最重要的變化,就是驅動終端側AI推理加速的高通AI引擎。

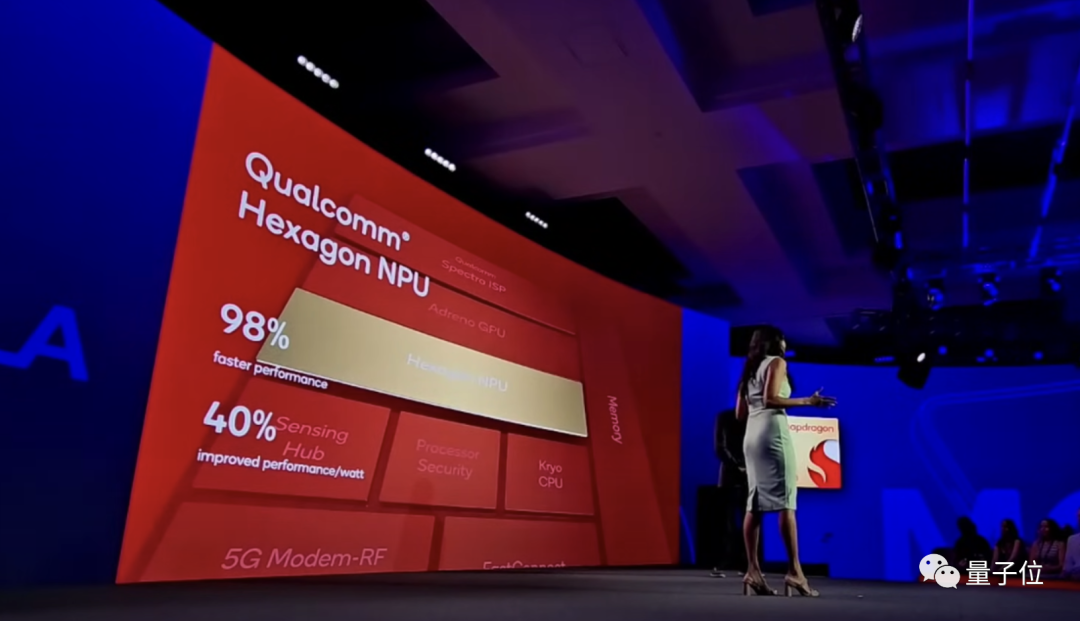

這個AI引擎由多個硬件和軟件組成,包括高通Hexagon NPU、Adreno GPU、Kryo CPU和傳感器中樞。

其中最核心、與AI最密切相關的,是Hexagon NPU。

高通公布的數據顯示,Hexagon NPU在性能表現上,比前代產品快98%,同時功耗降低了40%。

具體而言,Hexagon NPU升級了全新的微架構。更快的矢量加速器時鐘速度、更強的推理技術和對更多更快的Transformer網絡的支持等等,全面提升了Hexgon NPU對生成式AI的響應能力,使得手機上的大模型“秒答”用戶提問成為可能。

Hexagon NPU之外,第三代驍龍8在Sensing Hub(傳感器中樞)上也下了功夫:增加下一代微型NPU,AI性能提高3.5倍,內存增加30%。

值得關注的是,官方提到,Sensing Hub有助于大模型在手機端的“定制化”。隨時保持感知的Sensing Hub與大模型協同合作,可以讓用戶的位置、活動等個性化數據更好地為生成式AI所用。

而在內存方面,第三代驍龍8支持LPDDR5X,頻率從4.2GHz提高到了4.8GHz,帶寬77GB/s,最大容量為24GB。

更快的數據傳輸速度,更大的帶寬,也就意味著第三代驍龍8能夠支持更大更復雜的AI模型。

并且,此番高通在內存和Hexagon NPU矢量單元之間增加了直連通道,進一步提高了AI處理效率。

恰逢驍龍峰會期間,SK海力士還特別宣布,其產品LPDDR5T已經在高通第三代驍龍8上完成了性能及兼容性驗證,速度達到9.6Gbps。由此看來,搭載第三代驍龍8的手機在內存方面還有更多的選擇。

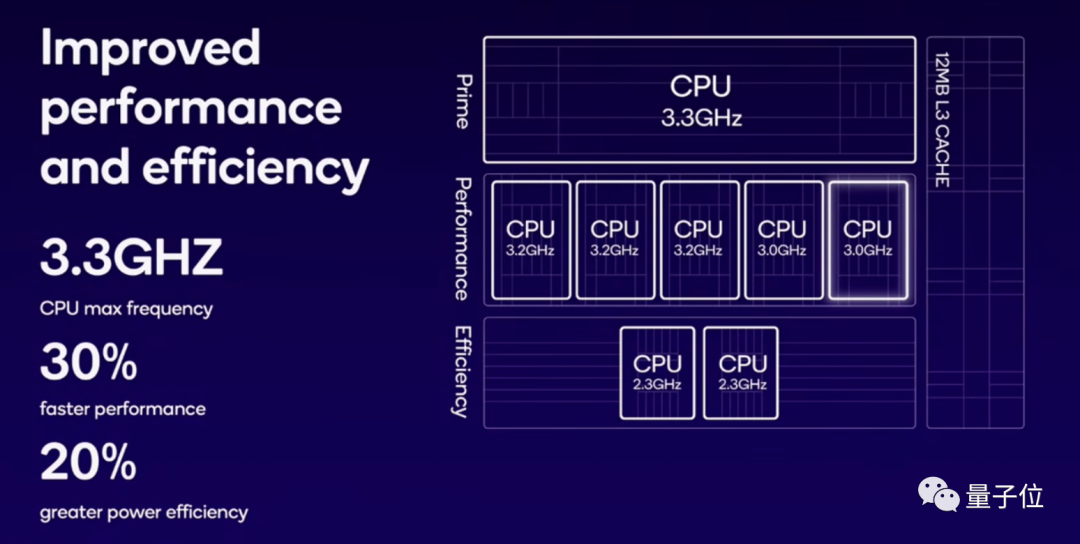

除此之外,在CPU方面,第三代驍龍8采用“1+5+2”架構(1個主核心、5個性能核心和2個能效核心),相較于前代的“1+4+3”,將1個能效核心轉換為性能核心。其中超大核頻率提升到3.3GHz,性能核心頻率提升到最高3.2GHz,能效核心頻率提升到2.3GHz。

新架構下,Kryo CPU性能提高了30%,功耗降低了20%。

GPU方面,第三代驍龍8則在性能和能效方面均實現25%的提升。

值得一提的是,AI引擎之外,第三代驍龍8的ISP、調制解調器等其他模塊,也已根植AI基因。

現在,高通的認知ISP是醬嬸的:

支持多達12層的照片/視頻幀實時語義分割;

融合生成式AI技術,支持聲控拍照和視頻編輯;

支持利用AI技術從視頻中刪除不需要的人和物;

支持AI擴展照片;

……

調制解調器同樣有5G AI處理器的加持:通過分析信號完整性和信噪比,AI能夠改善無線帶寬、延遲等性能指標。

由此看來,在大模型進手機的過程中,行業領軍者的硬件解決之道可以從兩方面來總結:

其一,是針對算力、內存、能耗三要素的性能提升和功耗平衡。

其二,是用AI來定義硬件,跟AI技術本身做更深層的結合。

不過,雖說硬件技術能解決大模型移植到智能終端的關鍵難點,但要想讓它真正落地應用,仍需要邁過另外一重門檻。

降低大模型軟件開發門檻

這道門檻,具體可以分解為兩個問題:

技術更新、體積更大的模型,如何快速實時地裝進手機?

裝進手機后,又要如何快速裝進手機以外的智能終端?

要想解決這兩大問題,就不能僅僅從硬件側入手,而同樣要在軟件開發上做好準備。

首先,需要先增強智能終端對不同大模型的適配能力,即使是架構算法存在差異也同樣能裝進手機。

即使最新大模型體積超出預期,也要能確保在不影響性能的情況下,將之應用到智能終端。

這里依舊以高通為例。

從最早在手機上運行10億參數Stable Diffusion,到快速基于驍龍8 Gen 3適配百億參數大模型,背后實際上還離不開一類軟件能力——

AI壓縮技術。

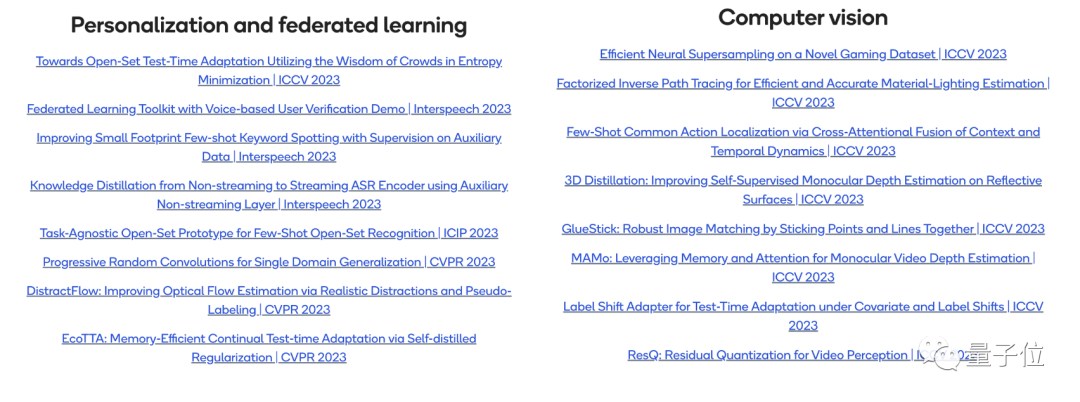

最新的AI壓縮技術,從高通今年發表在AI頂會上的幾篇論文可以窺見一斑。

像是這篇被NeurIPS 2023收錄的論文,就針對當前大模型的“基石”Transformer架構進行了量化相關的研究。

量化是壓縮AI模型的一種經典方法,然而此前在壓縮Transformer模型的時候,容易出現一些問題。

這篇論文提出了兩種方法來對Transformer模型進行量化,在確保壓縮效果的同時,進一步提升模型輸出性能,確保模型看起來“更小更好”。

然后,還需要增強大模型軟件在不同軟件終端之間的通用性,進一步加速落地。

對于大模型而言,從一個硬件設備遷移到另一個硬件設備,并沒有想象中那么容易。

不同的計算平臺之間,硬件的配置往往差異很大,電腦上能運行的大模型,放到手機上還真不一定就能立刻運行。

而這也正是阻礙大模型在種類繁多、部件繁雜的智能終端落地的另一重原因。

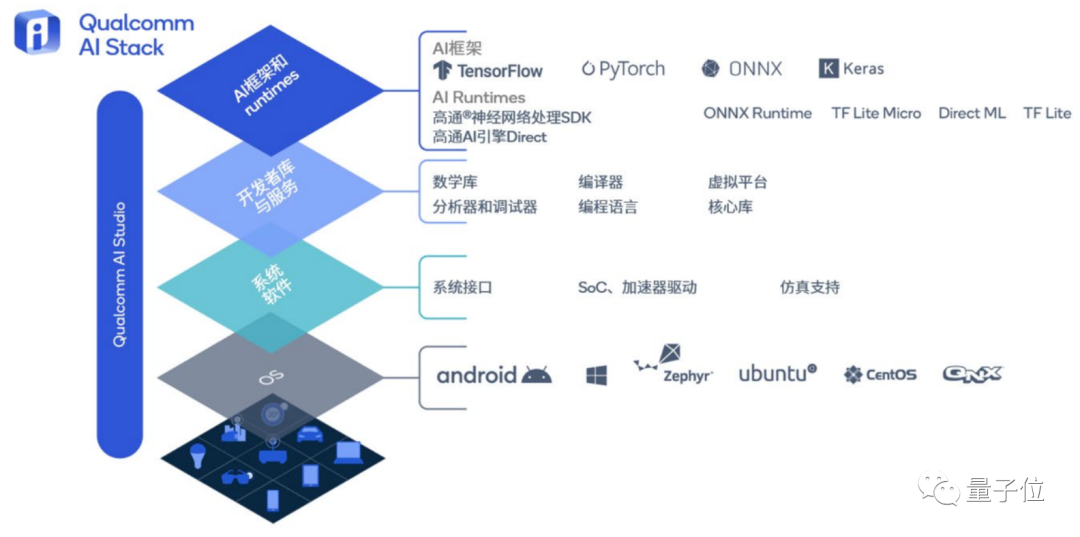

對此,高通的準備是一個“轉換器”一樣的角色:高通AI軟件棧。

這是一套容納了大量AI技術的工具包,全面支持各種主流AI框架、不同操作系統和各類編程語言,能提升各種AI軟件在智能終端上的兼容性。

不僅如此,這套軟件棧還包含高通AI Studio,相當于將高通的所有AI工具集成到一起,直接進行可視化開發。

其中,如AI模型增效工具包、模型分析器和神經網絡架構搜索(NAS)等都在里面。

AI軟件只需要在里面從設計、優化、部署到分析“走一趟流程”,就能快速轉換成在其他操作系統和平臺上也可以運行的軟件產品。

只需要一次開發,甚至是大模型軟件的開發,就能讓它在多個平臺運行,不需要擔心適配的問題,像Stable Diffusion就已經部署到其中,其他平臺也同樣可以隨取隨用了。

這樣一來,不僅僅是將百億參數大模型塞進手機,甚至還能將它塞進汽車、XR、PC和物聯網。

原本的設備類型繁多的缺點也能化為優勢,進一步加速大模型軟件的落地。

總結來看,大模型移植到智能終端所需的技術,不僅是硬實力,軟件上也同樣需要有所儲備。

所以,對于在大模型時代下蓄勢待發的移動端軟硬件廠商而言,究竟如何才能抓住這次難得的機遇?

或者說,各廠商要如何提前做好準備,才能確保大模型時代依舊屹立于技術浪潮之巔?

大模型時代需要怎樣的終端芯片

一個時代有一個時代的計算架構。

深度學習時代是如此,計算攝影時代是如此,大模型時代依舊如此——

無論軟硬件,「模力時代」下的智能終端芯片評判標準已經悄然生變。

一方面,對于硬件性能而言,芯片已經從單純的硬件性能對比、算力較量、功耗計算,逐漸轉變成對AI算力的比拼,甚至是對AI軟硬件技術能力的全面要求。

這種轉變,從大模型廠商巨頭的技術儲備棧變化可以窺見一斑。

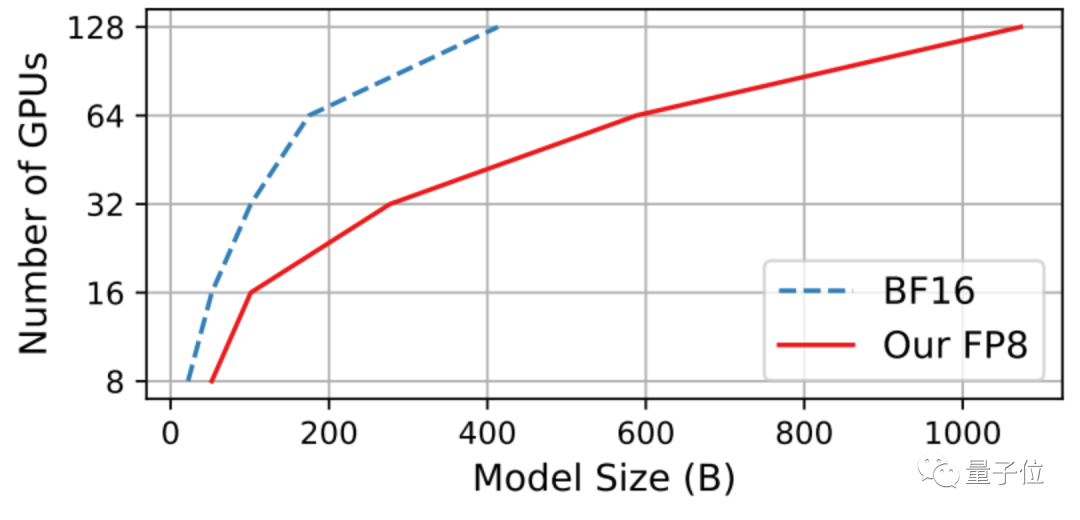

以微軟為例,這家科技巨頭和云廠商,近期開始注重起AI軟硬件結合的技術,如大模型訓練等。

在微軟前不久的一篇訓練研究中,就系統闡述了大模型在FP8精度下訓練的效果,能在同樣硬件成本下,訓練更大規模的大模型、同時確保訓練出來的模型性能。

△圖源論文FP8-LM: Training FP8 Large Language Models

以AI算法研究著稱的OpenAI,則被曝出有造芯的意向,開始朝硬件方向的技術發力。

顯然,從不同科技巨頭最新研究中能看出,在這個技術日新月異的時代,手握一張底牌就能抓住機遇、打出自身價值的概率,正變得越來越低。

如果還停留在“硬件公司造好芯、軟件公司做好算法”的階段,勢必只會被其他虎視眈眈的廠商超過,在「模力時代」失去已有的競爭力。

反觀硬件場景有優勢的芯片公司,亦是如此。

除了硬件性能的提升以外,與時俱進擴展軟件技術棧、提升軟硬件結合的AI能力,同樣不可或缺。

高通在前陣子推出的白皮書中就提到,將大模型部署到個人智能終端上,不僅要考慮硬件,也同樣需要考慮模型個性化、計算量等問題。

但相比等待大模型廠商去解決這些問題,高通選擇自己在軟件方面進行研究,最新成果也同樣實時寫成論文分享出來。

只有這樣,才能更好地了解算法軟件側對于硬件的需求,從而更好地提升芯片的性能。

另一方面,對于算力更受限、用戶范圍更廣的終端而言,未來的趨勢必然是無縫互聯。這就意味著,跨平臺適用性會成為AI解決方案的關鍵。

這種動向,從今年的驍龍峰會上發布的Snapdragon Seamless技術就能窺見一斑。

像是將平板上的照片,用鼠標就能“一鍵平移”到PC,在電腦上進行快速處理:

處理完畢后,還能將照片在另一個設備上打開,并用PC的鍵盤給它重命名:

即使只有一個設備擁有鍵盤和鼠標,也能對各類設備進行無縫控制,甚至讓AI軟件也無障礙在各個設備之間連接使用。

對于數據傳輸延遲不是問題的未來而言,打通多終端協作和互聯,勢必是智能終端的下一個未來:

不僅手機和PC等不同的終端設備之間可以共享數據、更可能讓同一套設備在不同的操作系統之間完成一系列流暢操作,像是手機和PC的音頻在耳機之間無縫切換:

之前只有在手機上能使用的AI應用,有了這套系統就能擴展到千萬臺智能終端設備上,包括PC、XR、平板和汽車。

這樣一來,大模型就不再會受限于某一臺設備、或是某一個操作系統,而是能快速將已經在一類終端中實現的AI能力快速套用到更多設備中,最終實現“萬物皆可大模型”的操作。

總結來看,在大模型時代下,AI廠商不僅需要具備軟硬件結合的能力,更需要提前布局智能終端萬物互聯的未來,以「連接」技術加速大模型在場景下的落地應用。

高通已經給出了自己的行動路徑。

對于其他不同企業而言,依舊要在場景中探索自身的價值,才可能在「模力時代」下找到新的出路。

(本文轉載自量子位公眾號)

關鍵詞: